İnsanlığın teknoloji ile ilişkisinde ilginç bir ikilem var. Yaşamı kolaylaştıracak, bize büyük yararlar sağlayacak teknolojilerin neredeyse her zaman ve kısa bir arayla bir de olumsuz uygulamasını geliştiriyoruz. Alfred Nobel’in stabilize ettiği nitrogliserin, bir yanda tünelleri açmayı kolaylaştıran bir buluş, diğer yandan sayısız insanın ölümünden ve milyonlarca yapının yıkılmasından sorumlu bir patlayıcı.

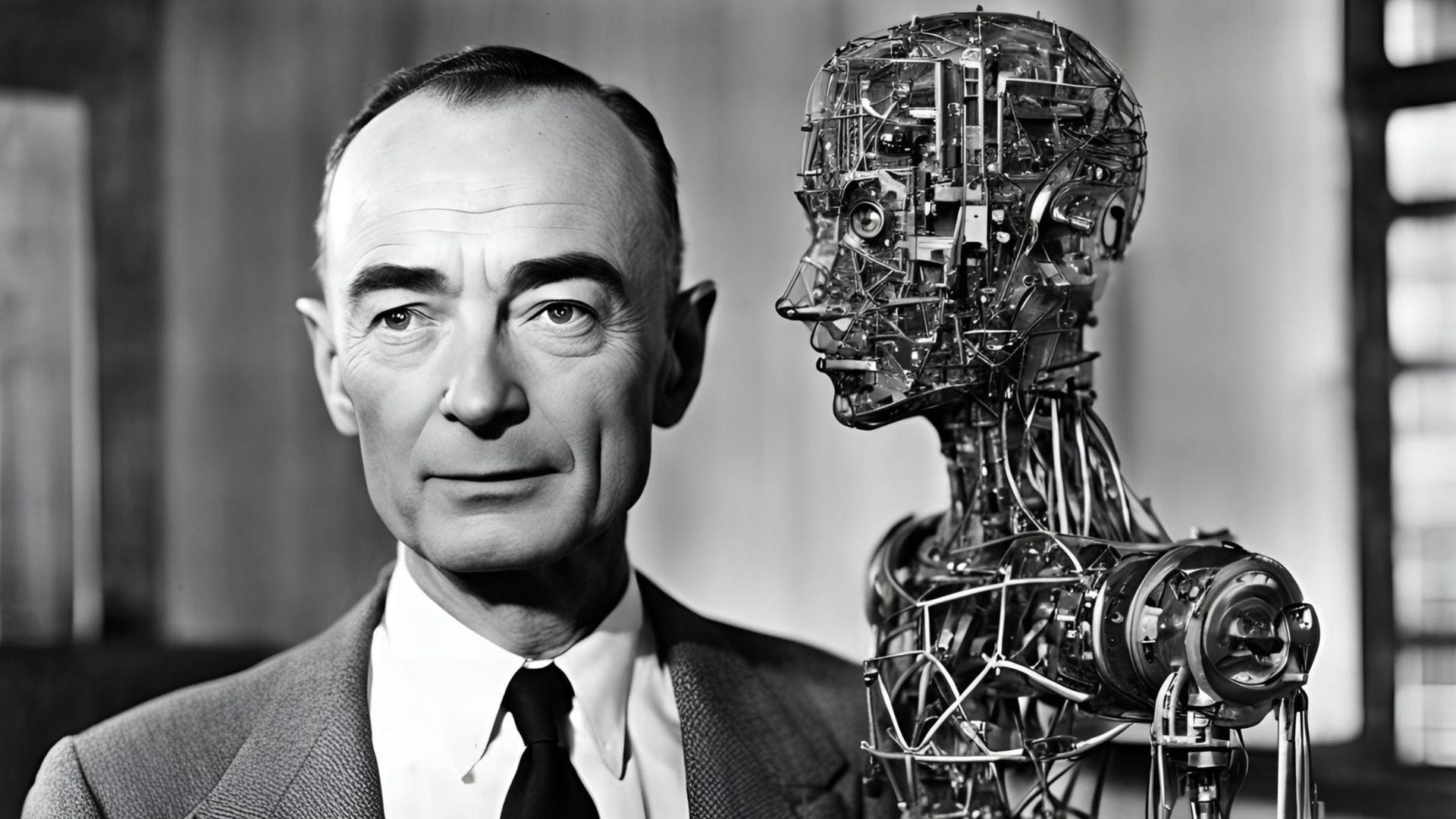

Fizikçi Lise Meitner uranyum atomunu bölerek zincirleme reaksiyon ile çok güçlü bir enerji kaynağı buluyor. Yıl 1938. Oppenheimer’ın ilk atom bombası? 16 Temmuz 1945. Meitner’ı kimse hatırlamıyor günümüzde, Oppenheimer ise bir filmin kahramanı.

Örnekler sayısız. Sosyal medyalar toplumları ve değişik grupları birbirlerine tanıtacak, yaklaştıracak ve iletişim kurduracak bir yenilik olarak ortaya çıktılar. Kısa sürede, siyasal kutuplaşma ve etnik düşmanlıkların körükleyicisi platformlar haline geldiler.

Yapay zekâ bu ikilemli geleneğin yeni bir örneği diyenler çoğunlukta. Bir yanda, hekimlere tanı, hakimlere kanun ve içtihat desteği verecek, istihdamı liyakat temeline oturtacak, bankaların kredi geri ödeme riskini azaltacak ve devlet yardımlarını doğru kişilere ulaştıracak bir süper asistan var. Öte yanda, Genel Yapay Zekâ (Artificial General Intelligence) gerçekleşirse Teknolojik Tekillik (Singularity) ile bize hükmedebilecek ve belki insanlığı yok edecek bir teknoloji.

Ancak, yapay zekânın diğer örneklerden önemli bir farkı var. Bu süper asistan, birinci günden, önyargılı, ırkçı ve cinsel ayırımcı sonuçlar üretmeye başladı. Uygulamaya koyulduklarında, algoritmaların tanı önerilerinin kadınlar ve etnik gruplar için önemli yanlışlıklar içerdikleri, Amerika’da mahkemelerde zencilere daha uzun cezalar önerdikleri, Amazon gibi büyük şirketlerin istihdam sürecinde kadınları tamamen gözardı ettikleri, banka kredilerini kadın ve azınlıklara vermekten kaçındıkları ve bazı Avrupa ülkelerinde farklı dinleri temsil eden isimleri devlet yardım listelerinden sildikleri ortaya çıktı.

Buradaki ilginç nokta, ikili kullanım teknolojilerinin tersine yapay zekânın zararlı uygulamalarının arkasında bilinçli insan kararlarının bulunmaması. Kimse nükleer fisyonu atom bombası yapma kararında olduğu gibi ayırımcı algoritmalar yapmaya çalışmıyor. Yapay zekâyı ayırımcı ve önyargılı yapan, algoritmaların oluşturulma süreci. Makine Öğrenimi (Machine Learning) sürecinde, algoritmalar, insanların üretmiş olduğu metinler, fotoğraflar, videolar, tıp, hukuk ve ticari kaynaklar kullanılarak eğitiliyor. Bu kaynaklar, doğal olarak, insanlığın bilinçli ve bilinçsiz değer yargılarını içeriyor.

Bir İK müdürü farkında olmadan kadınların erkeklerden daha az kalifiye olduğuna inanabilir ve personel seçimleri bundan bir ölçüde etkilenebilir, ama yüzbinlerce İK müdürünün atama kararlarıyla eğitilen bir algoritma için bu bir önyargı değil, istihdam sürecinde kullanılması gereken bir kriter teşkil eder. Aynı olgu, arşivlenmiş tıp tanıları ve mahkeme, kredi ve devlet yardım kararları için de geçerli.

Bir sonraki aşama daha da tehlikeli. Internet’ten algoritma eğitim amaçlı alınabilecek metinlerin bitmek üzere olduğunu biliyoruz. OpenAI, Antropic, Mosaic, Meta ve Google gibi Oluşturucu Yapay Zeka (Generative AI) yapımcıları “yineleme” (iteration) metoduyla kendi metinlerini üretmeyi ve algoritma eğitiminde bunları kullanmayı planlıyorlar. Yani insanların önyargılarıyla eğitilen algoritmalar aynı unsurları daha da belirgin yapan metinler üretecek ve bunlar Makine Öğrenimi’nde kullanılacak.

Bu soruna nasıl bir çözüm bulunabilir sorusuna farklı yanıtlar var. OpenAI gibi şirketler aynı yoldan giderek sorunun kendiliğinden yok olacağını iddia ediyorlar. Google Deep Mind’ın Satranç ve Go gibi oyunları öğrenme ve tercüme yapabilme özelliklerini Makine Öğrenimi’ne eklemleyerek olumlu bir yere gideceklerini düşünüyor. Meta çocuk ve hayvanların bağlam farkındalığını ve sağduyu sezgilerini algoritmalara ögretmeyi ve bunu geliştirmeyi planlıyor.

Bir de benim Düşünce Kuruluşum No Bias AI? gibi çözümün gerçek zekâ içeren ve algoritma eğitimi için veritabanlarına gerek duymayan Makine Muhakemesi (Machine Reasoning) paradigmasında yattığına inananlar var.

Makine Muhakemesi’nin insan verilerinden algoritmaya geçen önyargı ve ayırımcı unsurları elimine etmesi ve bize bir süper asistan kazandırması çok olası. Ancak tedbir almazsak, bizi bu teknolojinin karanlık yüzüne, yani Teknolojik Tekilliğe daha hızla götürmesi de söz konusu.

O zaman Oppenheimerın ünlü cümlesindeki “dünyaları” kelimesinin yerine “insanlığı” koymamız gerekecek.

Saniye Gülser Corat Kimdir?

Robert Koleji’nden ve 1978 yılında Boğaziçi Üniversitesi Siyaset Bilimi Bölümü’nden mezun olan Saniye Gülser, yüksek lisansını Belçika’daki Avrupa Çalışmaları’nda doktorasını Ottawa’da Carleton Üniversite’sinde yaptı. Uluslararası Araştırma Gelişme Merkezi ve Kanada Uluslararası Gelişme Ajansı’nda eğitim, sosyal ve ekonomik kalkınma, kurumsal güçlendirme, toplumsal cinsiyet eşitliği, yerel yönetişime teknoloji transferi ve iklim değişikliğine konularında danışmanlık yapan Corat, dünyanın çeşitli yerlerinde Dünya Bankası, UNDP gibi kurumlarda insani gelişmişliği artırıcı projelerde çalıştı. Yaklaşık 10 yıl Kanada’daki uluslararası bir danışmanlık şirketinin CEO’luk görevini üstlenen Corat, Unesco’nun Cinsiyet Eşitliği Bölümü’nde direktör olarak da görev aldı. Gülser Corat, UNESCO’da direktörlüğü sırasında ‘Yapabilsem, Kızarırdım’ ve ‘Yapay Zeka ve Cinsiyet Eşitliği’ adlı iki raporunu hazırlandı. Gülser Corat, yayınladığı bu iki araştırma raporuyla 2020’de Women in Tech Global Ödül Töreni’nde ‘Küresel Liderlik Ödülü’ne layık görüldü. UNESCO’daki görevinden ayrılan Corat, cinsiyet eşitsizliğiyle olan savaşını devam ettirmek için NO BIAS AI? adında bir düşünce kuruluşunu hayata geçirdi. Corat, 2024 yılında Global Turks tarafından yurtdışında kariyer yapan en başarılı Türk seçildi.